„AlphaGo“ kompiuteris su dirbtinio intelekto sistema, kuri visus nustebino, įveikdama geriausius pasaulio žaidėjus strateginiuose stalo žaidimuose, kuriuos žaidžiant, reikia ir intuicijos, tapo dar protingesnis, pranešė jos kūrėjai žurnalo „Nature“ straipsnyje.

Tai – patobulinta dirbtinio intelekto „AlphaGo“ versija, pavadinta „AlphaGo Zero“. Jos pagrindinis skiriamasis bruožas – savarankiškas mokymasis. Mokslininkų teigimu, tai yra svarbus žingsnis į priekį kuriant sistemas, kurios priartėtų prie žmonių gebėjimų, o gal juos ir pralenktų, ir net be žmonių įsikišimo.

Tai – patobulinta dirbtinio intelekto „AlphaGo“ versija, pavadinta „AlphaGo Zero“. Jos pagrindinis skiriamasis bruožas – savarankiškas mokymasis. Mokslininkų teigimu, tai yra svarbus žingsnis į priekį kuriant sistemas, kurios priartėtų prie žmonių gebėjimų, o gal juos ir pralenktų, ir net be žmonių įsikišimo.

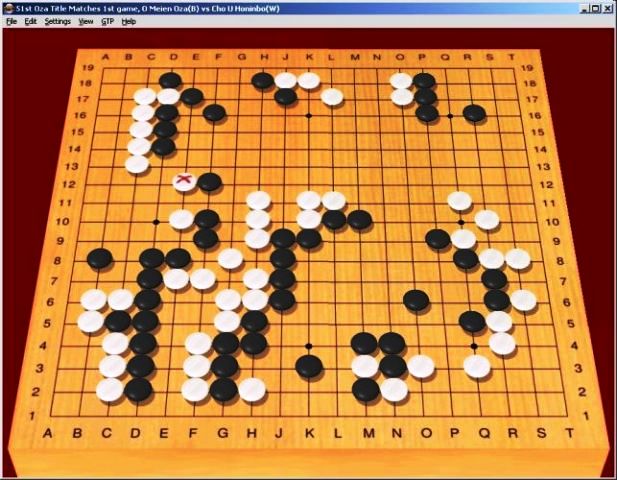

Dirbtinio intelekto sistema „AlphaGo Zero“ per kelias dienas išmoko žaisti senovės Kinijoje prieš 3000 metų išrastą stalo žaidimą „Go“, dviejų žaidėjų žaidžiamą baltomis ir juodomis figūromis. Laikoma, kad tai – pats sudėtingiausias dviejų žaidėjų žaidimas, o jo galimų kombinacijų skaičius viršija Visatos atomų skaičių.

Po trijų mokymosi dienų „AlphaGo Zero“ buvo išbandytas žaidžiant prieš savo pirmtaką – dirbtinio intelekto sistemą „AlphaGo“, kuri jau anksčiau buvo įveikusi šio žaidimo pasaulio čempioną – 2016 metais „AlphaGo“ rezultatu 4-1 laimėjo prieš 18 kartų pasaulio čempioną Lee Se-Dol.

Iš 100 partijų „AlphaGo Zero“ prieš „AlphaGo“ laimėjo visas.

Analizuodamas žaidimą „AlphaGo Zero“ ne tik pats atrado bendras, jau žinimas ir naudojamas žaidimo strategijas, bet jas galiausiai atmetė. Pasirodė, kad „AlphaGo Zero“ sugalvojo savo, naujoviškus žaidimo žingsnius.

Skirtingai nuo savo pirmtakų, kurie mokėsi, analizuodami milijonus „Go“ žmonių žaidimų, o po to žaisdami prieš patį save, „AlphaGo Zero“ to nedarė.

Pasak šios dirbtinės intelekto sistemos kūrėjų iš britų įmonės „DeepMind“, visoms ankstesnėms „AlphaGo“ versijoms buvo pasakyta: „šioje padėtyje žaidimo specialistas padarė tokį ėjimą, o esant tokiam kauliukų išsidėstymui – tokį.“

„AlphaGo Zero“ šį etapą praleido. Vietoj to, jam buvo užprogramuota, kad sistema gaus tašką, jei laimės žaidimą, ir tašką praras, jei pralaimės. Ir įvestos žaidimo taisyklės.

Žinodama tik taisykles, sistema nagrinėjo žaidimą, žaisdama pati prieš save – pradedant nuo visiškai atsitiktinių ėjimų ir analizuojant, kaip reikia žaisti, kad gauti trokštamą tašką. Tai buvo bandymų ir klaidų procesas, vadinamas sustiprintuoju mokymosi (angl. reinforcement learning).

Skirtingai nuo savo pirmtakų, „AlphaGo Zero“ nebebuvo suvaržytas žmonių žinių ir patirties ribomis.

Be to, „AlphaGo Zero“ turėjo tik vieną neuronų tinklo imitatorių ir keturis procesorius, tuo tarpu kai „AlfaGo“ – 48 procesorius ir kelis neuronų tinklus. Besimokydamas „AlphaGo Zero“ sužaidė 4,9 milijonus mokomųjų žaidimų per tris dienas, o „AlphaGo“ – 30 milijonų žaidimų per kelis mėnesius.

„Žmonės linkę manyti, kad mašininis mokymasis yra susijęs su milžiniškų duomenų kiekių analize ir didžiuliais skaičiavimais, bet iš tikrųjų mes, dirbdami su „AlphaGo Zero“ pamatėme, kad algoritmai gali būti daug svarbesni“, teigia šio projekto vadovas Deividas Silveris (David Silver). „Pasirodė, kad dirbtinis intelektas, pagrįstas sustiprintuoju mokymu, buvo geresnis nei tie, kurie remiasi žmogaus kompetencija. Tačiau tai tikrai nėra „pabaigos pradžia“, reiškianti, kad iškyla grėsmės patiems dirbtinio intelekto kūrėjams – žmonėms, nes „AlphaGo Zero“, kaip ir visos kitos sėkmingos dirbtinio intelekto sistemos, yra labai ribotos, palyginti su žmonėmis ir netgi su gyvūnais. „AlphaGo Zero“ gebėjimas mokytis savarankiškai gali atrodyti visiškai autonomiškas, tačiau yra svarbus skirtumas – žmonės turi bendro pobūdžio žinias, jie gali analizuoti įvairiausias situacijas ir priimti atitinkamus sprendimus, o specializuotos kompiuterinės programinės įrangos sistemos – ne“.

„DeepMind“ per pastaruosius kelis metus parodė, kad galima sukurti programinę įrangą, kuri būtų pranašesnė už žmones tam tikrose srityse – bet tai nereiškia, kad ji savaime tampa protinga. Taip pat verta paminėti, kad „AlphaGo“ tobulėjo ne todėl, kad pati programinė įranga būtų siūliusi, koks mokymosi būdas geresnis, tai darė žmonės. Tačiau jei taip įvyktų, jau reikėtų pradėti nerimauti“, teigė Andersas Sandbergas (Anders Sandberg) iš Oksfordo universiteto Žmonijos ateities instituto (the Future of Humanity Institute at Oxford University).

Self-taught, ‘superhuman’ AI now even smarter: makers

Mastering the game of Go without human knowledge, Nature (2017). nature.com/articles/doi:10.1038/nature24270

Daugiau:

„Intel“ paskelbė netrukus išleisianti pirmuosius lustus, skirtus dirbtinio intelekto sistemoms

Dirbtinis intelektas vaizduotės spąstuose – jis bus kitoks nei tikimės

Muzikos kūrėjai gali pamėginti pagroti duetu su dirbtinio intelekto sistema

Dirbtinis intelektas sukūrė pirmąją melodiją

Kuriama dirbtinio intelekto sistema, kuri pati galėtų programuoti

Robotų revoliucija: intelektualios automatizuotos darbo jėgos didėjimas